(Bài viết đã được đăng trên báo Tuổi trẻ Cuối tuần, số ra ngày 14/03/2025. Mời bạn đón đọc. Dưới đây là phiên bản Writer’s Cut.)

Gần đây, nhân dịp xảy ra những drama chính trị hài hước ở trời Tây, “bong bóng” mạng xã hội của tôi xôn xao chuyện đặt LLMs cạnh tư duy phản biện. Có người đề xuất cho các LLMs “đấu khẩu” với nhau, người khác gợi ý làm chatbot chuyên “phản biện” bán cho đám thích cãi tay đôi. Ý tưởng cũng thú vị đấy.

Thử tưởng tượng cảnh hai người bất đồng thuê LLMs cãi hộ. Trong lúc họ ung dung uống bia hơi hoặc massage ở đâu đó, avatar Facebook của họ tự động đăng bài, cãi qua cãi lại. (Về lý thuyết thì làm được.) Người lạ khắp nơi tụ tập hít hà, dán mắt vào cái đấu trường giả ấy, tự thấy hừng hực, dù không khí tranh luận thua xa bất kì một cái chợ nào ở Hà Nội.

LLMs: phản biện giả, tư duy thật ở đâu?

Tuần trước, tôi chứng kiến một cảnh hài như thế diễn ra trong lớp mình dạy. Tôi thiết kế bài tập thuyết trình tin tức khoa học để khuyến khích các nhóm chủ động cập nhật những tiến bộ trong lĩnh vực này. Hôm ấy, một nhóm đưa tin về một phát minh y học mới – chủ đề không dễ vì nhiều thuật ngữ y khoa xa lạ với cả lớp. Để sinh viên tập trung hơn, lớp có quy tắc: đặt câu hỏi để nhận điểm cộng. Thật ra, chỉ cần đặt vài câu hỏi cơ bản, xoay quanh các thuật ngữ ấy cũng đủ làm sáng tỏ vấn đề rồi.

Vậy mà, tôi để ý thấy một sinh viên ngồi dưới dùng LLMs tạo câu hỏi rồi đọc lên. Câu hỏi nghe chung chung và không ăn nhập lắm đến nội dung bài thuyết trình, khiến nhóm trên bục không thể trả lời. Nhưng thay vì thừa nhận mình không biết, một thành viên trong nhóm thuyết trình đáp lại bằng một câu trả lời từ LLM khác, đọc thẳng từ điện thoại. Cuộc đối thoại giữa hai “người phát ngôn cho LLMs” khô khốc, cứng nhắc. Cả hai em đều có kết nối tới kho tàng kiến thức nhân loại, vậy mà chẳng ai nhận ra cuộc “thảo luận” đó đã lạc khỏi chủ đề chính. Sau đó, tôi đã ngồi lại trò chuyện với cả lớp về việc này.

Ngay trong môi trường giáo dục – nơi đáng ra tư duy phải được mài giũa – các em sinh viên năm Nhất tận dụng LLMs để làm mờ ranh giới giữa tư duy thật và giả.

Nhưng liệu cách sinh viên của tôi làm có phải là cách đa số người dùng sử dụng LLMs? Tuy không dị ứng với LLMs, nhưng tôi khó chịu khi người ta dùng LLMs “đẻ” thẳng ra cái gì đấy rồi cứ thế gửi đi. Chúng ta cầm điện thoại, tưởng mình nắm được chìa khóa tri thức trong tay, nhưng thực tế chỉ đang chơi trò điền từ.

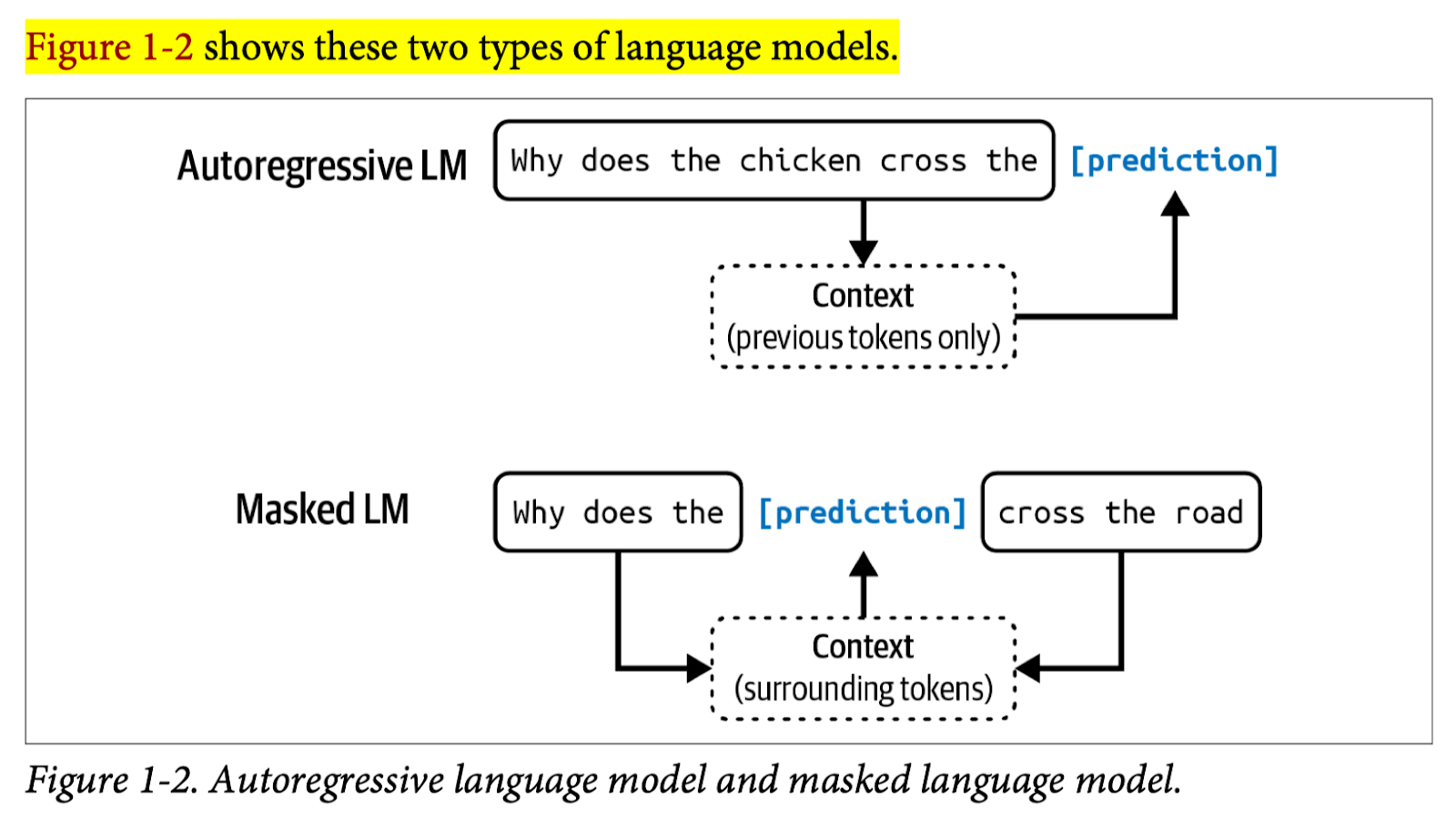

Bản chất của LLMs và các mô hình ngôn ngữ nói chung là thu dữ liệu, dự đoán dựa trên khuôn mẫu và điền vào chỗ trống. Như ví dụ trong hình bên dưới (1), ở câu “Tại sao gà băng qua …?”, LLMs có khả năng chọn “đường” chứ không phải “bát canh”. Không phải vì LLMs hiểu con gà không hề thích … bát canh nóng, mà vì dữ liệu huấn luyện đã cung cấp như thế. LLMs chỉ nhớ và làm theo. Chúng ta – con người – mới là kẻ gán ý nghĩa cho câu trả lời đó. Không những vậy, ở ví dụ trên, ta đã hai lần gán ý nghĩa cho LLMs. Lần đầu, chúng ta cho LLMs học dữ liệu đúng. Lần thứ hai, chúng ta thấy LLMs tạo ra câu trả lời bèn gán ý nghĩa cho việc này và cho rằng LLMs “hiểu” về con gà.

Cách mô hình ngôn ngữ đưa ra dự đoán. Nguồn: Sách AI Engineering: Building Applications with Foundation Models của tác giả Huyen Chip.

“Gán ý nghĩa là gì?”, bạn hỏi tôi. Ví dụ gần gũi hơn nhé. Nếu bạn nhìn dấu vết lá trà sót lại dưới đáy ly và thấy hình đầu lâu, rồi tin đó là điềm báo nguy hiểm, thì ai liên kết các dữ kiện và tạo ra ý nghĩa ấy? Rất có thể là chính bạn. Với LLMs cũng vậy. Và khi dùng nó nhiều, ta bắt đầu có lầm tưởng rằng nó “biết”, nó “hiểu”, nó “thông minh”. Ta quên LLMs chỉ đang dự đoán.

Giáo sư Monica Lam, giám đốc Phòng thí nghiệm Trợ lý ảo mã nguồn mở của Đại học Stanford, giải thích về hiểu lầm này của người dùng như sau. Khi ta hỏi và LLMs trả về kết quả, ta tưởng nó đã phân tích, đánh giá, và hiểu (đã suy nghĩ), vì trong trường hợp của con người thì phải hiểu mới trả lời được. Nhưng thật ra LLM chỉ là một máy nhớ khổng lồ và không hề đi qua từng bước để ra kết quả (2). Đúng là con người cũng bắt đầu suy luận từ việc thu thập quan sát qua từng trường hợp, nhưng chúng ta nhanh chóng chuyển sang suy luận dựa trên mối quan hệ nguyên nhân – kết quả, các trải nghiệm trong thế giới thực và cả những suy tưởng trừu tượng. Con người có thể suy luận mà không nhất thiết cần rất nhiều dữ liệu, khác với cách máy nhớ LLMs làm việc. (3)

Nhưng là máy nhớ thì vẫn nhớ sai. Theo một nghiên cứu vào đầu năm 2025 của BBC, Đài phát thanh truyền hình của Anh, tỉ lệ AI trích nguồn hoặc cung cấp sai thông tin từ 13% – 19%. (3). Làm sao ta biết LLMs dự đoán đúng không? Làm sao chắc ý nghĩa ta gán vào là phù hợp?

Giáo sư Christopher D. Manning, Giám đốc Phòng thí nghiệm Trí tuệ Nhân tạo Đại học Stanford, cùng cộng sự nghiên cứu độ chính xác của LLMs trong bối cảnh tư vấn luật (2). Ông nói: “Bạn không muốn tin chúng đâu. Chúng thật sự kém trong việc hiểu và áp dụng các văn bản luật.” Như thế, một sinh viên năm Nhất có thể coi chữ tạo ra bởi LLMs là chân lý, còn các chuyên gia thì luôn đặt dấu hỏi. Dường như, chất lượng đầu ra của LLMs lại phụ thuộc vào trình độ của người dùng. LLMs có thể giỏi “phản biện”, nhưng hỏi “tại sao” hay “đúng không” là việc của con người.

Tư duy phản biện: Không phải cứ cãi là giỏi

Là một người hướng dẫn tư duy phản biện cho … người, tôi thấy nhầm lẫn giữa “phản biện” và “tư duy phản biện” rất phổ biến. “Phản biện” thường bị hiểu là bốp chát lại cho đã miệng, cho đối phương tâm phục khẩu phục. Nhưng tư duy phản biện sâu hơn thế – nó gồm nhiều thao tác trong tâm trí như đọc hiểu, lắng nghe sâu, phân tích, kiểm chứng, lập luận, để nhận thức rõ hiện thực. Bạn có thể “phản biện” ầm ĩ mà không có tư duy phản biện. Ngược lại, bạn có thể tư duy phản biện mà chẳng cần mở miệng.

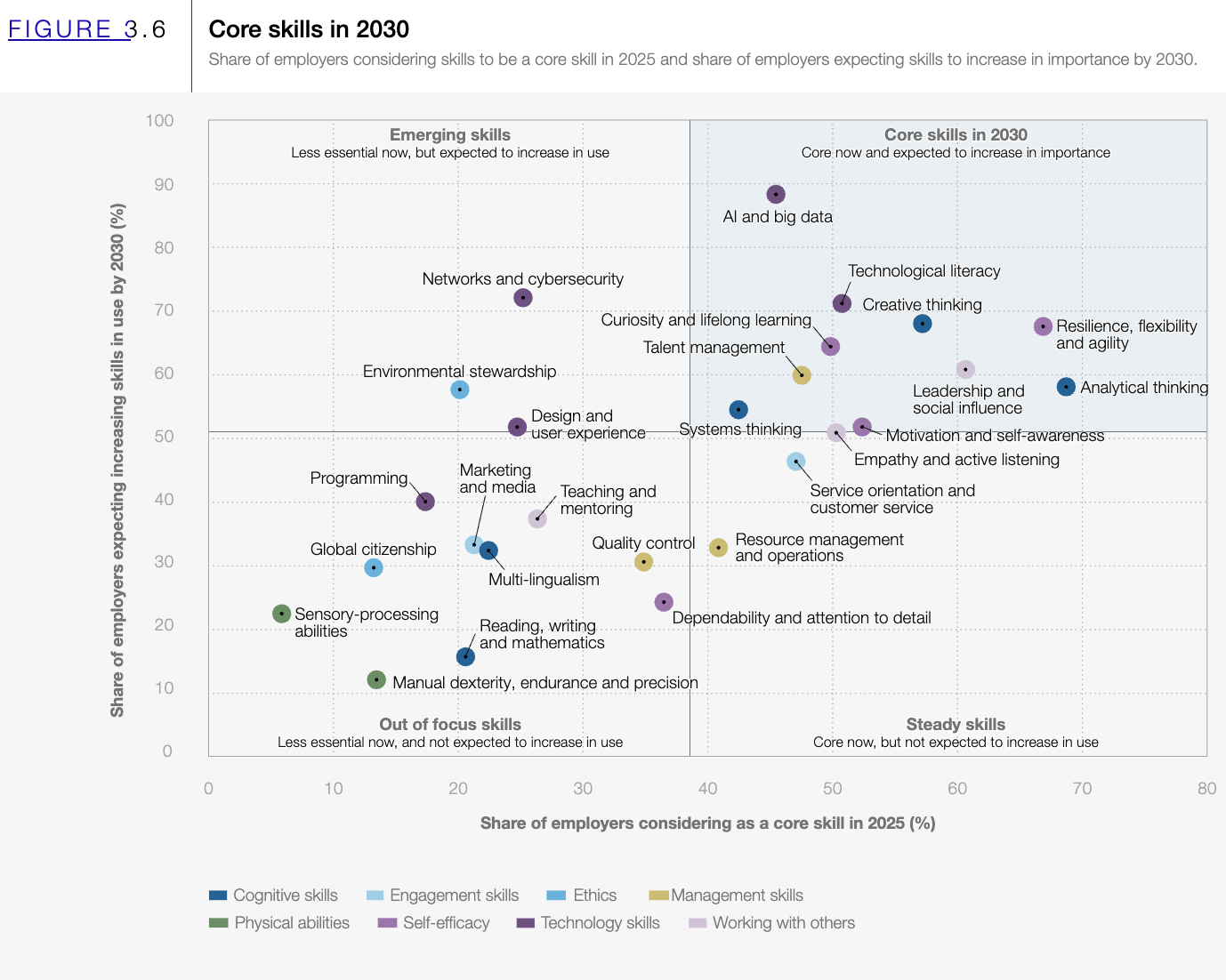

Tư duy phân tích và hệ thống, hai thành phần của tư duy phản biện vẫn được coi những kỹ năng cốt lõi vào năm 2030. (Báo cáo của Diễn đàn Kinh tế thế giới WEF 2025 (5)

Các dự báo về xu hướng kỹ năng lao động tương lai nhắc nhở chúng ta: tư duy phản biện vẫn sẽ luôn cần thiết. Nhưng đừng mơ đi vài workshop là xong. Tư duy phản biện, như mọi kỹ năng thuộc về tâm trí khác, được rèn qua mạng lưới neuron thần kinh. Bạn giỏi phân tích vì bạn luyện tập liên tục, nên não bộ hình thành những kết nối bền vững. Không dùng thì nó yếu đi – thần đồng hay thiên tài cũng không thoát khỏi quy luật “tay làm hàm nhai” của sinh học.

Tới đây, chắc bạn đã thấy một vòng lặp: bạn cần thực hành tư duy phản biện để trở thành chuyên gia, và bạn phải là chuyên gia để đánh giá được chất lượng chữ nghĩa do LLMs tạo ra. Ỉ lại vào tính năng Deep Research của LLMs thường xuyên, bỏ qua việc đọc hiểu đơn thuần, sớm muộn cách tư duy của chúng ta sẽ cùn đi. Và với trình độ tầm thường, ta sẽ lại tưởng LLMs nói toàn lời vàng ý ngọc.

Tôi cũng không thích cụm từ “bộ não thứ hai” (second brain) mà một số cộng đồng xây dựng hệ thống quản lý tri thức hay gọi. Tên gọi ấy ám chỉ việc phát triển một hệ thống lưu trữ tri thức bên ngoài “bộ não thứ nhất” ta đang dùng. Nhưng nó cũng gợi ý rằng Google (hồi xưa) và LLMs (thời nay) có thể thay thế được trí nhớ và tư duy của ta. Còn thực tế, khi bạn tỉ mẩn ghi chú, xây dựng commonplace book, hay viết blog, bạn không chỉ đang lưu trữ tri thức – bạn đang phát triển chính bộ não của mình. Những dòng ghi chú, những bài viết logic, cô đọng và chính xác trên giấy hay trên màn hình là biểu hiện của những kết nối neuron ngày một rõ ràng trong tâm trí.

LLMs không làm được điều đó thay bạn. Và bạn cũng không nên để LLMs làm điều đó thay bạn. Ta tư duy phản biện để giữ lại tính người.

Định nghĩa con người để tương tác với máy phù hợp

LLMs gây náo động vì ta tin nó làm được (lại gán ý nghĩa, thực ra là bắt chước) những đặc trưng của con người: suy luận và ngôn ngữ. Nhưng nếu để máy “suy nghĩ” hộ, ta lại phải hỏi: Còn gì là người? Điều gì quy định tính con người (humanness)? Ngoài những đặc điểm khác biệt trong suy luận đã nêu ở trên, theo tác giả Faisal Hoque, triết học đưa ra vài gợi ý (7).

Thứ nhất, con người có thể nhận biết giới hạn nhận thức của mình. Như câu nói nổi tiếng của Socrates “Tôi biết là tôi chẳng biết gì”. Còn với LLMs, GS. Monica Lam nói phải tập cật lực chỉ để cho chúng trả về kết quả “em không biết.”

Thứ hai, con người có khả năng nhận ra và phá bỏ mô thức để suy nghĩ và tạo ra cái mới. Từ chữa lành bản thân hay các phong trào xã hội, mọi thay đổi bắt đầu từ việc nhận diện bối cảnh và thói quen vô thức. LLMs chỉ dự đoán dựa trên dữ liệu cũ. Copywriter kỳ cựu Sói Ăn Chay (Huỳnh Vĩnh Sơn) tự tin nói với tôi, LLMs có thể viết giống anh của quá khứ, nhưng nó không biết được ngày mai anh viết gì.

Thứ ba, con người có hệ giá trị. LLMs có thể tạo ra cả tá lập luận đa chiều, nhưng dùng cái nào thì lại phụ thuộc vào điều bạn coi trọng. Brainstorm với AI tiện lợi đấy, nhưng có một nhóm bạn viết, một biên tập viên để tranh luận thì đáng giá hơn, nếu bạn coi trọng mối quan hệ chuyên nghiệp hơn mỗi tính năng sửa bài.

Cuối cùng, con người cần “có mục đích” để thấy mình sống. Dù tuổi gì, ta vẫn tò mò về vị trí của mình trong cuộc đời, trong vũ trụ. Vì vậy, ra quyết định mà có nhận thức về mục đích của mình là rất quan trọng. Dùng công cụ gì cho phép ta gọi tên mục đích của mình, hoặc để nó làm những việc tầm phào, còn ta dành sự chú tâm cho những việc có ý nghĩa hơn.

Dù làm gì đi nữa, xin đừng tư duy ít hơn: Gợi ý dùng LLMs để phát triển tư duy phản biện

Trong bộ phim Interstellar đang được chiếu lại, tôi mê mẩn hai con robot TARS và CASE. Chúng có thể lưu trữ và truy xuất các thông tin, tính toán nhanh, phụ trợ cầm lái, giải cứu nhanh chóng, và nhất nhất nghe lời con người. Tôi ước mình có chúng để phiêu lưu cùng vì an tâm, chứ không phải thay cho tôi.

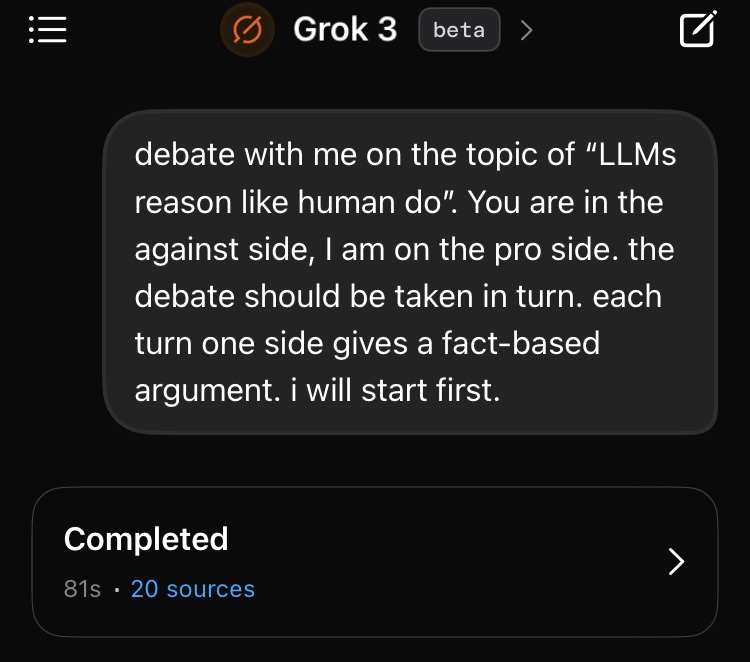

Thừa nhận LLMs có khả năng khổng lồ, tôi vẫn đang học cách sử dụng nó cho có ích. Sau đây là một số cách cụ thể tôi hay làm với LLMs để mài giũa tư duy của mình. Một, vì muốn được suy nghĩ nên tôi bắt LLMs tạo câu hỏi cho mình qua câu lệnh: “I want … Ask me one at a time to …” (Tôi muốn làm … Hãy hỏi tôi từng câu hỏi một để tôi …). Hai, khi muốn làm rõ và tăng sự hiểu của mình với một chủ đề, tôi cho LLMs “ăn” tài liệu và đặt câu hỏi để tôi ôn tập. Tôi sẽ là người tìm từ tài liệu và tự tóm tắt để trả lời. Ba, để rèn kỹ năng tư duy đa chiều, tôi đặt lệnh để LLMs trở thành đối thủ của mình trong một cuộc tranh biện. Vì biết khả năng “bịa” của LLMs, tôi sẽ cho nó ở phe tôi biết rõ khi nào nó “xào nấu” cái gì. Tất nhiên, những cách này đều có người phụ thay vì dùng LLMs. Tôi thường coi trọng giá trị kết nối với con người hơn sự tiện lợi.

10 năm trước, bộ phim Interstellar ra mắt, nhưng những gì nó mô tả về trợ lý robot đang tồn tại với chúng ta đây rồi. Tôi tin chắc chắn trí thông minh nhân tạo rồi sẽ tốt hơn rất nhiều. Nhưng chúng ta hãy viết, hãy nghĩ, hãy học, hãy đặt câu hỏi, phân tích, nghiên cứu vì đó là cách để giữ lấy chính mình.

Nếu có đi chợ và cãi nhau cho vui, tôi hi vọng có thể tự mình làm chuyện đó. Dù bạn dùng công cụ gì đi nữa, xin đừng tư duy ít hơn.

Lời cám ơn

Cám ơn Cát Tường, Anh Sơn (Báo Tuổi trẻ Cuối tuần) đã đọc bản nháp và góp ý để bài viết này được hoàn thiện hơn. Cám ơn anh Sói Ăn Chay, chị Trang đã nói chuyện với em về AI. LLMs thay thế quái được mọi người trong lòng tôi?

Hình ảnh featured là bức tranh cuối đời của danh họa Edward Hopper, Two Comedians, được vẽ năm 1966. Edward mất vào năm 1967. (6)

✨Niềm vui ✨ khi viết bài này phóng lên không trung 🌏 🚀, vượt qua cả đường Kármán, nhờ được tiếp thêm nhiên liệu từ sự ủng hộ 🧧💸 của chị Khải Đơn, Phan Nhi, cô Lan Anh, Hoàng Tâm, Yến Phạm, Ngân và An, Rosie, chị Linh Trịnh, chị Quỳnh Như, Mắt Bét, Saoline, Law, Trân, Diên An, cô Vân, Thảo, Vân Anh và nhiều bạn đọc khác.

Tham khảo

(1) Sách AI Engineering: Building Applications with Foundation Models của tác giả Huyen Chip

(3) Mitchell, M., & Krakauer, D. C. (2023). The debate over understanding in AI’s large language models. Proceedings of the National Academy of Sciences of the United States of America, 120(13), e2215907120. https://doi.org/10.1073/pnas.2215907120 https://pmc.ncbi.nlm.nih.gov/articles/PMC10068812/

(4) Nghiên cứu của BBC 2/2025 https://www.bbc.co.uk/aboutthebbc/documents/bbc-research-into-ai-assistants.pdf

(5) Báo cáo Future of Jobs – Diễn đàn kinh tế thế giới 2025

(6) https://en.wikipedia.org/wiki/Two_Comedians

(7) Sách Transcend: Unlocking Humanity in the Age of AI của Faisal Hoque.